Norske redaktører tar Vær Varsom-plakaten på alvor. En ny Facebook-funksjon kan gjøre etikkjobben umulig.

For første gang har vi fått eksemplifisert et av de store problemene med at Facebooks datamaskiner blir for smarte.

Facebook har de siste årene brukt enorme ressurser på å forbedre innholdsalgoritmene sine: Spørsmål som «Hvilke bilder bryr du deg om?» og «Hvilke saker er du interessert i?», er utfordringer Facebook prøver å løse bedre, raskere og mer presist for hver dag som går.

Det siste steget i denne utviklingen er at de jobber knallhardt med å levere deg innhold som er relatert til det du ser ut til å være interessert i.

Store datamengder

For mange, og det gjelder også undertegnede, har Facebook i stor grad gått fra å være en tjeneste hvor man følger med på livet til sine venner, til en plattform for å følge med i nyhetsbildet. Facebook-nyhetsstrømmen min er fylt med artikler fra små og store aktører, i stor grad basert på et utvalg jeg selv har gjort.

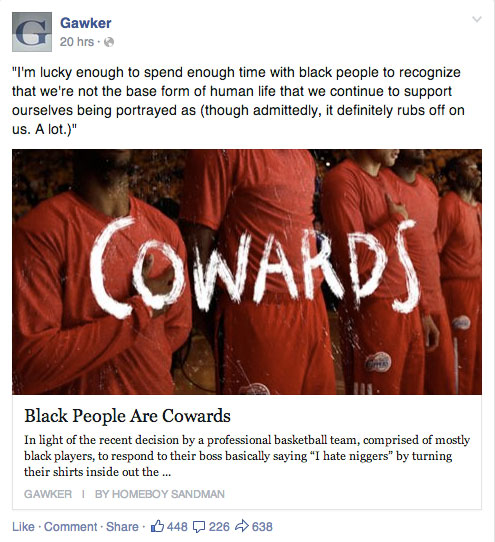

I eksempelet nedenfor blir jeg servert en sak fra Gawker om rasisme i amerikansk fotball:

Etter å ha trykket på saken, lest den, og kommet tilbake til Facebook, har nyhetsstrømmen oppdatert seg med en ny boks i underkant av Gawker-saken, hvor Facebook viser meg innhold som de mener kan være relevant for det jeg akkurat har lest:

Denne listen er satt sammen av en rekke algoritmer, blant annet gjenkjenning av tekst og bilder.

I praksis betyr det at Facebook støvsuger store deler av nettet, indekserer innholdet i en database, og lager koblinger mellom de ulike innholdssegmentene som måtte befinne seg ute på nettet.

I utgangspunktet er det ikke noe galt i dette: Det øker Facebooks nytteverdi for deg som bruker, og gjør Facebook bedre, som en relevant leverandør av aktualitetsstoff.

Men det finnes også en skyggeside.

Når Facebook identifiserer barnemishandlere

NRKbeta har antagligvis de mest årvåkne leserene i Norge, og i går fikk vi en e-post fra Knut Vegard Fosse, som tipset oss om en sak han fikk levert i Facebook-nyhetsstrømmen sin.

Christoffer-saken, hvor åtteringen som ble mishandlet av sin stefar og til slutt døde av skadene, ble mye omtalt av norsk presse gjennom 2009 og 2010. Ingen norske redaktører valgte å identifisere hverken stefaren eller moren.

En Dagbladet-sak fra 2009 om skjending av Christoffers grav har blitt mye delt på sosiale medier de siste dagene. Artikkelen inneholder blant annet et pikselert bilde av stefaren og moren, en normal praksis for sladding av bilder i nasjonal og internasjonal presse.

Det aktuelle bildet er ikke direkte relatert til Christoffer-saken, men det er det eneste kjente bildet av de to sammen, og Dagbladet har derfor valgt å bruke dette som en illustrasjon på de to involverte.

Dessverre har det seg sånn at enkel bildesladding ikke er nok i 2014.

Bildet som Dagbladet valgte å pikselere var hentet fra Ringerikes Blad, som har omtalt moren og stefaren i en kontekst som ikke har noe med Christoffer-saken å gjøre. I den uavhengige saken ble både navn og alder til moren og stefaren offentliggjort.

Facebooks bildegjenkjenningsalgoritmer klarte raskt å koble det pikselerte bildet opp mot originalversjonen, selv om originalversjonen var usladdet, og publisert hos en annen nyhetsaktør i en ikke-relatert kontekst.

Som en konsekvens av dette ble Knut Vegard Fosse presentert for en sak som både avslørte moren og stefarens navn og bilde.

Dette betyr at bildegjenkjenningsteknologien som Facebook bruker, er blitt så raffinert at enkel sladding av ansikter ikke lenger er en velfungerende form for anonymisering.

I praksis betyr dette at Facebook identifiserer både moren og stefaren, stikk i strid med at alle norske redaktører har forsøkt å holde de anonyme.

– Ikke hørt om lignende saker

Kjersti Løken Stavrum, generalsekretær i Norsk Presseforbund, har ikke hørt om lignende saker tidligere:

– Jeg har ikke hørt om lignende saker, men har visst at disse algoritmene kommer til å by på nye etiske problemstillinger, sier Stavrum.

Utviklingen i den digitale sfæren går ofte raskere enn regelverket, og Stavrum ser absolutt problemer med at Facebook har mulighet til å gjøre disse koblingene:

– For folk som eventuelt har stilt opp til fotografering under løfte av å være anonym, eller der et bilde er tatt i en annen sammenheng og så senere blir misbrukt, så er dette et problem. Vær Varsom-plakatens regler for publisering gjelder uavhengig av teknologiens muligheter., sier Stavrum, og utdyper:

– Problemet oppstår når andre, som ikke er bundet av plakaten, tar seg friheten til å begå det bransjen mener er uetisk – uten å tenke gjennom konsekvensene av det og selvfølgelig uten å ta ansvar for det., sier Stavrum.

– Trygghet i dag er usikkerhet i morgen

Ståle de Lange Kofoed, fagmedarbeider ved Institutt for Journalistikk, er bekymret for kombinasjonen av rask teknisk utvikling og manglende digitalkompetanse hos norske redaksjoner:

– Problemet er at ting ligger på nett for evig tid, mens teknologien forandrer seg. Da er det veldig viktig å følge med på den tekniske utviklingen. Trygghet i dag er usikkerhet i morgen, sier Kofoed.

– Valgt å avpublisere

Ringerikes Blad, som hadde artikkelen hvor det usladdede bildet stammet fra, bekrefter at de i dag har avpublisert saken:

– Etter at vi igjen er gjort kjent med at saken har spredd seg uvanlig mye, har vi valgt å avpublisere, sier Øyvind Lien, nyhetsredaktør i Ringerikes Blad.

Øyvind Lien sier videre at avpubliseringen ikke er en direkte konsekvens av denne konkrete koblingen hos Facebook:

– Vi har ikke fått tips om Facebooks tekniske koblinger spesielt, men vi er gjort kjent med at linker er spredd og kommentert.

– Facebook skaper ikke eget innhold

På spørsmål om hvorvidt Facebook ser på dette som problematisk, svarer Jan Fredriksson hos Facebooks PR-byrå Northern Link følgende:

– Facebook er en platform som ikke skaper eget innhold, men fungerer som en aggregrator for andres innhold. Standard rutine for fjerning av innhold er at våre brukere rapporterer saker.

Fredriksson bekrefter også at Facebook ikke har automatiske algoritmer som sensurerer innhold før det kan postes hos tjenesten:

– Det er ingen automatiske algoritmer som sensurerer innhold i forkant av publisering. Alt sjekkes manuelt av våre moderatorer før en eventuell sensurprosess settes i gang. Når det er gjort har vi noen muligheter for å automatisk sensurere lignende innhold.

– Dette kan få følger

Kjersti Løken Stavrum tror at denne saken kan få følger for hvordan man behandler saker i sosiale medier fremover:

– Dette eksempelet viser at redaktørene og redaksjonene må være enda mer årvåkne ved automatisk lenking og kanskje måtte skru dette av hvis de henter stoff fra andre publikasjoner som vi ser her. Jeg tror også vi vil se langt færre anonyme bilder som følge av dette, og dessuten vil det være enda viktigere å følge debattfeltene, sier Stavrum, og utdyper:

– Vi ser allerede at redaksjonenes bruk av Facebook skaper etisk problematisk farvann. Kontroversielle saker som for eksempel postes på Facebook og debatteres der, er vanskeligere å moderere. Jeg tror det er verdt å stoppe litt opp før man deler saker – og bilder, som vi ser her.

Finnes det flere eksempler?

Dette er det første eksempelet vi i NRKbeta har sett på at Facebooks innholdsalgoritmer fører til store medieetiske problemstillinger. Men vi vet også at vi har blant landets beste og mest oppmerksomme lesere.

Har du andre eksempler på saker hvor Facebook kobler sammen innhold på en måte som skaper problemer? Fortell oss om det i kommentarfeltet!