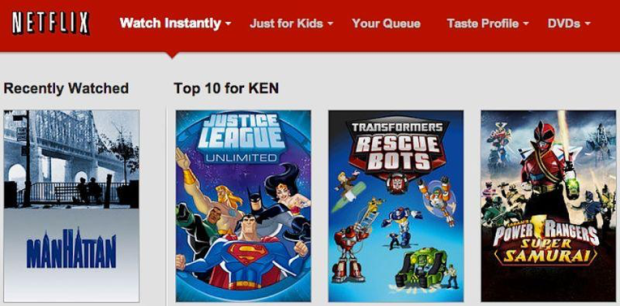

I løpet av de siste årene har flere hendelser synliggjort hvordan maskinlæringssystemer og algoritmer kan begå tabber med komiske og/eller fatale konsekvenser. Mange av oss har sikkert opplevd hvordan Netflix har sett sammenhenger i seervaner og innhold som ikke henger på greip:

Image may be NSFW.

Clik here to view.

Bildegjenkjenningen til Google Photos har klassifisert bilder av afroamerikanere som gorillaer. Under en gisseltagning i Sidney i 2014 økte Uber prisene sine kraftig som en konsekvens av den høye etterspørselen i området – helt etter algoritmeboka, men neppe en ønsket konsekvens.

Google Photos, y'all fucked up. My friend's not a gorilla. pic.twitter.com/SMkMCsNVX4

— Jacky Alciné (@jackyalcine) June 29, 2015

Her på South by Southwest-konferansen i Austin er det ingen mangel på nye teknologier eller idéer som skal redde eller snu opp ned på verden vi lever i: Virtual reality, flyvende biler og Hyperloops, kunstig intelligens og butler-roboter. Samtidig er det også en gryende tendens til teknologi-skepsis og økende bevissthet rundt de etiske problemstillingene som dukker opp når hele virkeligheten skal kvantifiseres og samles inn som datapunkter.

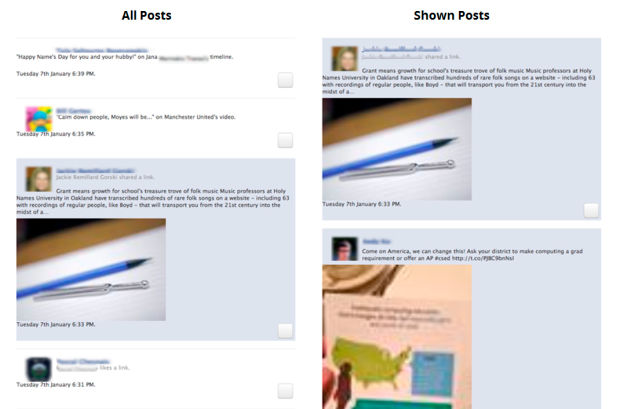

I en studie fra 2015 trodde 60% av deltakerne at Facebook-feeden var en enkel, kronologisk liste over ting vennene har postet og likt. De var ikke klar over at den er basert på en utstudert og kompleks algoritme-styrt filtrering

Christian Sandvig har forsket på hvordan publikum oppfatter og reagerer på tjenester som baserer seg på algoritmer. I en sesjon med tittelen «Algoritmisk vanvidd» hevder Sandvig at algoritmene er i ferd med å bli moderne myter; ugjennomtrengelige, uoppnåelige, og uforståelige. Siden vi som brukere ikke kjenner til mekanismene bak algoritmene, konstruerer vi «folkehistorier» og teorier om systemene vi bruker.

Algoritmiske misforståelser

Moderne digitale tjenester utformes ofte på en måte som skjuler detaljene og mekanismene bak systemet, for å oppnå et sømløst design. Et av Sandvigs forskningsprosjekter gikk ut på å tydeliggjøre «sømmene» bak systemet, og eksponere logikken bak algoritmene. Forskerne implementerte en versjon av Facebooks News Feed som faktisk var en kronologisk liste for brukeren, og markerte samtidig det innholdet Facebook-algoritmen hadde valgt å fremheve i tjenesten.

Clik here to view.

Deltagerne i studien ble bedt om å beskrive hvordan de trodde Facebook-algoritmen fungerte og hvorfor feeden var som den var. Respondentene hadd ulike og spredte teorier om disse mekanismene. Noen av dem bar preg av at vi har en tendens til å personifisere systemene vi bruker til daglig.

Mange beskriver Facebook-algoritmen som et slags altseende øye, som aldri fullt ut kan forstås eller kjennes.

Sammensetningen av Facebook-feeden er med på å forme oss og kulturen vi lever i, uten at vi kjenner til mekansimene bak algoritmene. Ifølge Sandvig er det ikke sikkert at Facebook har så god oversikt heller. Sandvig diskuterte ulike prinsipper for å designe algoritmestyrte systemer på en etisk forsvarlig måte, ved å gjøre «systemsømmene» synligere og gi større muligheter for brukeren til å overstyre eller deaktivere algoritmene.

Trenger vi en ed?

– «Vanlige» utviklere og designere blir bedt om å løse tekniske problemstillinger de ikke nødvendigvis ser konsekvensene av, eller er komfortable med å implementere. Hver gang gjennom historien hvor en yrkesgruppe har oppnådd slik uforholdsmessig makt, har man kommet frem til en kodeks som avgrenser og definerer hva som er «innenfor». Det har skjedd med leger, advokater og journalister. Trenger vi en slags «Hippokratisk ed» for utviklere? spør Microsoft-forskeren Kate Crawford i et panel på konferansen.

Facebookfeeden består i stor grad av matvideoer og bursdagshilsner. Om vi ikke nødvendigvis kan forklare hvorfor de dukker opp, er det kanskje ingen stor krise. Men hva om utfallet av algoritmen har større konsekvenser? Ifølge en artikkel i Ars Technica baserer NSA seg på maskinlæring for identifisering av mål for droneangrep. Og Facebook har patentert løsninger for å gi kredittvurdering basert på data de høster om deg på plattformen. Det er noe annet enn kattebilder.

I forutsigbar amerikansk stil er selv de største teknologiskeptikerne her i Austin preget av en dyp skepsis til lovgivning og statsregulering.

Men er en «dataetisk ed» noe bedre? Og isåfall; hva skulle det stått der?

Clik here to view.

Clik here to view.

Clik here to view.

Clik here to view.

Clik here to view.