De første datamaskinene var kompliserte og sårbare, og bare eksperter klarte å bruke dem. I dag bruker vi datamaskiner hele tiden, uten å tenke over det og uten å vite det. Hvordan kom vi hit? Her er litt historie og noen tanker om fremtiden.

I starten, for omtrent 70 år siden, var datamaskiner store, dyre, og vanskelige å lage. Etter hvert gjorde utviklingen i elektronikk at ting ble bedre. Noen av forbedringene som kom gav oss raskere maskiner, mens andre gjorde dem mer brukervennlige – blant annet med hjelp av stadig bedre datagrafikk.

Nå ser vi at datamaskinen er i ferd med å bli erstattet av andre og mer spesialiserte enheter.

Datamaskinen blir usynlig for oss.

Den spede begynnelsen

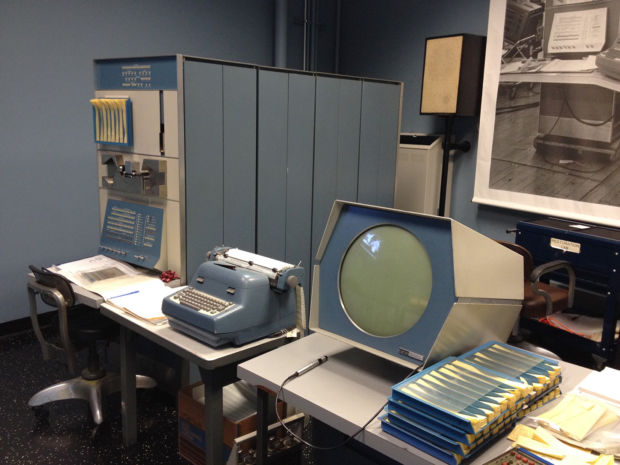

På 50-tallet var en datamaskin et komplekst og sårbart apparat som gikk i stykker hele tiden. Like fullt la man mye penger og forskning i å gjøre datamaskinene bedre. Tanken bak var at datamaskinen – en ny, elektronisk regnemaskin – skulle klare å gjøre store beregninger mye raskere enn hva de mekaniske regnemaskinene klarte.

Datamaskinene var imidlertid vanskelige å bruke. Regneoppgavene måtte programmeres på hullkort av papp, legges i fine stabler i en kortleser på maskinen, og så måtte man vente noen timer eller dager mens maskinen jobbet seg igjennom oppgavene.

Svarene kunne leses ut på strimler av papir dersom alt gikk bra med både innlesningen, kjøringen og utskriften, og dersom programmet ikke hadde feil i seg.

Om maskinen brøt sammen, noe som tidvis skjedde, måtte man også begynne på nytt.

Fra regnemaskin til datamaskin

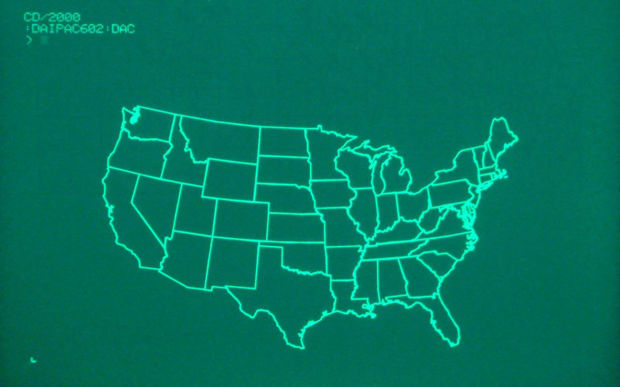

I 1960 kom maskinen PDP-1. Dette var den første maskinen på markedet som hadde skjerm. Brukeren fikk nå en mulighet til å ha en dialog med maskinen mens den kjørte. Ved å se på skjermen kunne man følge med på hva som skjedde. I tillegg var maskinen så rask at man kunne skrive kommandoene på et tastatur og se resultatet på skjermen etterpå.

Dette var en interaktiv maskin. Maskinen skulle her føye seg etter brukerens arbeidstempo, og ikke omvendt. Den skulle ikke bare gis regneoppgaver og stå og jobbe for seg selv, den skulle bearbeide data i samspill med brukeren. Dette var nytt.

Skjermen var laget slik at den både kunne vise tekst og grafikk. Og en dag hadde noen laget programmer hvor man kunne styre figurer på skjermen mens de beveget seg. Et av verdens aller første dataspill, Spacewar!, hadde blitt til.

Trykk på videoen for å se hvordan spillet Spacewar! ser ut:

Her skulle brukerne styre to raketter i verdensrommet og forsøke å skyte på hverandre. Den raske grafikken viste seg å være så fengende at spillet ofte ble vist fram for mulige kjøpere. Og PDP-serien av datamaskiner ble veldig populær, det ble laget nye modeller i over 30 år.

Elektronikk og skjermer

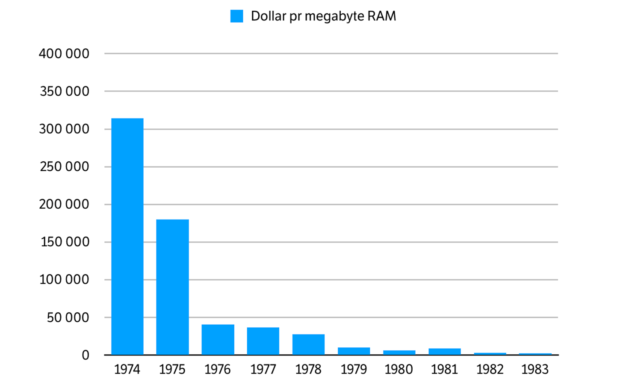

Skjermen på PDP-1 var en såkalt vektorskjerm. Når den viste grafikk var bildene bygget opp ved hjelp av rette streker. Grunnen var at det krevde liten lagringsplass (RAM) å vise fram et skjermbilde når det ble definert på denne måten. RAM-brikker, komponentene man trengte for å holde på bilder i hukommelsen til maskinen, var på denne tiden veldig dyre. Så det å bruke streker i opptegningen holdt prisene nede.

Dagens framgangsmåte, det å bruke små punkter (piksler), gir mye bedre gjengivelser av bilder, men krever også mye mer lagringsplass. Det å lagre skjermbildene som piksler ville gjort at maskinene hadde blitt altfor dyre. Og ingen kunne kjøpt dem.

Midt på 70-tallet gikk imidlertid utviklingen av elektronikk og elektroniske kretser veldig fort. Produsentene klarte å krympe innmaten i komponentene, og det gjorde at RAM-brikkene fikk større kapasitet enn før, men uten å bli dyrere. Sagt på en annen måte: Lagringsplass ble billigere. Dette gjorde at også datamaskinene ble billigere. Nå var det mulig for langt flere å ta dem i bruk.

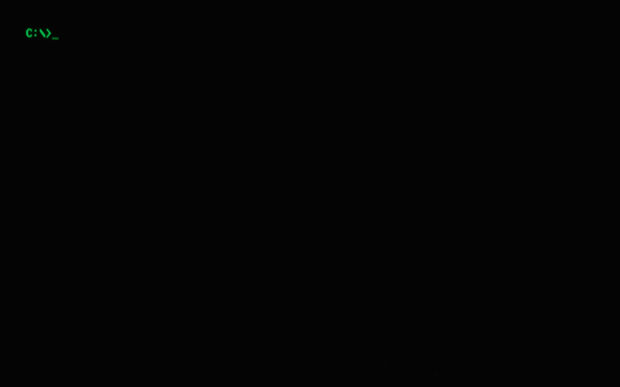

I 1981 lanserte IBM en datamaskin de kalte Personal Computer. IBM hadde fra før laget systemer for kontorbruk der mange ansatte delte en maskin. Produktidéen til IBM var nå at hver ansatt skulle ha sin egen. Datamaskinen ble personlig.

PC-en ble en så stor suksess at produktnavnet PC ble det nye ordet for datamaskin. Men PC-en var vanskelig å forstå og bruke. Den var laget for tekstbehandling og regnskapsføring, og den kunne ikke tegne grafikk.

Konsepter som filer, programmer og lagring av data, som måtte forstås for å kunne bruke maskinen, ble presentert på abstrakte måter. Mange brukere bladde i håndbøker og gikk på kurs, uten å bli så veldig mye klokere. Datamaskinen forble mystisk og utilgjengelig.

Andre valgte å bruke prisnedgangen på elektronikk til andre ting. Da komponentene ble bedre og billigere valgte noen av de som laget spilleautomater å bytte ut vektorskjermene med pikselskjermer. Teknologen var ikke lengre for dyr. Og pikselskjermene gjorde at spillene nå fikk raskere grafikk og store, fargerike flater.

Hjemmedatamaskinene var basert på nettopp denne ideen. Dette var enkle og billige maskiner som stort sett ble brukt til å spille spill. TV-en, som man jo hadde fra før, ble brukt som skjerm.

Hjemmedatamaskinene fikk stor betydning: De gjorde det mulig for langt flere å lære seg hva en datamaskin er og hva den kunne brukes til. En ny generasjon av programmerere kom til. De hadde lært seg koding hjemme, på fritiden, og ikke på jobb eller i et fag på et universitet.

Trykk på videoen for å se spillet Pole Position 2 i aksjon på Atari 7800:

Grafikk og brukervennlighet

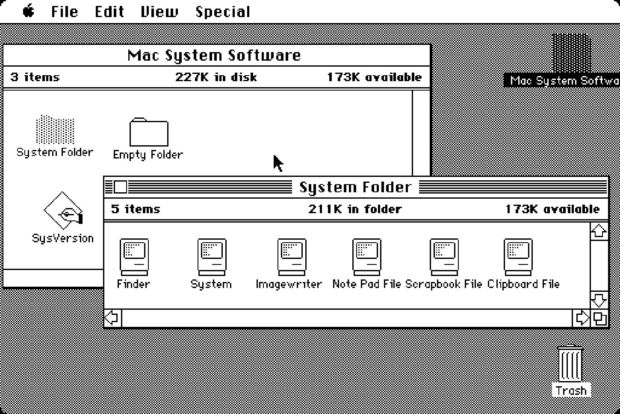

Xerox Alto var den første datamaskinen som viste programmer på skjermen slik man gjør i dag, med bruk av ikoner, menyer og vinduer.

Den kom i 1973, nesten 10 år før IBMs PC. Produsenten, Xerox, tok konsepter fra den virkelige verden, puttet dem inn i datamaskinen, og brukte datagrafikk til å gjengi dem på en realistisk måte.

Alto var en maskin som det var lett å lære seg.

Brukerne kjente igjen skrivebordene og arkivmappene fra kontorene sine som ikoner på skjermen. Alto ble dessverre ingen suksess. Den hadde en pikselskjerm, noe som på denne tiden gjorde den for dyr, og utvalget av programmer var ikke stort nok. Men, de samme tankene om brukervennlighet dukket opp på ny senere – i en maskin som skulle bli verdensberømt.

Trykk på videoen for å se hvordan grensesnittet fungerer på en Xerox Alto:

I 1984 lanserte Apple maskinen Macintosh, et slags motstykke til IBMs PC. Macen var en alternativ kontormaskin – og den var tydelig inspirert av Alto. Apple hadde valgt som prinsipp at god interaksjon med brukeren var viktigere enn lav pris og høy ytelse. Macen ble etter hvert veldig populær til kontorbruk, spesielt innen grafisk design og på universiteter.

Grensesnittet på Macen var mye mer forståelig enn PC-en sitt. Og etter hvert forstod IBM og samarbeidspartneren Microsoft at Apple hadde lyktes med å skape et godt produkt. Brukerne hadde nærmest et religiøst forhold til maskinene sine. Microsoft kom deretter med sitt svar, Windows. Windows ble standard på PC-er, både hjemme og på kontoret.

På dette tidspunktet var det ikke lenger noen tvil: Folk ville ha brukervennlige maskiner, og det betød at maskinene måtte ha god grafikk. Brukerne fikk det etter hvert som de ville, men det oppstod samtidig et problem: De fargerike og detaljerte skjermbildene gjorde at maskinene ble trege. Det var for mye jobb for maskinen å regne ut og tegne opp alt sammen.

Spesialisering

Løsningen ble grafikkort. Dette var en elektronisk krets som kunne plugges inn i maskinen. Grafikkortet jobbet i parallell med resten av maskinen og hadde kun én oppgave: Å regne ut og tegne opp grafikk.

Dette hjalp veldig, ting gikk igjen raskere. Det at grafikkortet var spesiallaget for å jobbe med helt bestemte oppgaver gjorde at ytelsen ble god uten at man å måtte betale så mye for det.

På starten av 90-tallet begynte kappløpet om god grafikk for alvor. Brukerne ønsket seg stadig flere farger, høyere oppløsning og enda jevnere bevegelser på skjermen.

Produsentene tilbød raskere og raskere grafikkort. Teknologien ble etter hvert så god at det å vise ikoner og programmer i vinduer på skjermen ikke var så veldig krevende lengre. Maskinene hadde fått overskudd til å gjøre andre ting også. Behovene – og mulighetene – tok nye retninger.

Tre dimensjoner

Spill som Doom (lansert i 1993) og Quake (i 1996) gjorde at mange oppdaget tredimensjonal grafikk. I disse spillene kunne man bevege seg fritt rundt inne i en virtuell verden, modellert som hus, og skjermen viste grafikk som var mye mer realistisk enn før. Begge spillene ble store suksesser. Realisme og lynrask interaksjon var kult.

På slutten av 90-tallet startet en ny periode med spesialisering. Doom og Quake hadde blitt så populære at man begynte å lage egne grafikkort og prosessorer for å håndtere tredimensjonal grafikk. Prosessorene fikk egne navn, de ble kalt GPU-er. GPU-ene tok jobben med å regne ut og tegne opp de virtuelle verdenene man bevegde seg rundt i. De ble etter hvert svært raske. Prisene på elektronikk fortsatte å gå ned, og spesialiseringen gjorde også denne gangen dette ikke ble for dyrt for brukerne.

Det neste tiåret utviklet grafikk-teknologien seg voldsomt. Nye og kraftigere GPU-er ble stadig lansert, og samtidig ble det laget enda mer avanserte og ressurskrevende spill. Ett eksempel er Grand Theft Auto IV (lansert i 2008). Her kunne man bevege seg fritt rundt i store, detaljerte bymiljø med ekstremt naturtro grafikk.

Likevel var det å spille spill bare en av mange måter å bruke en datamaskin på. Dataspillene fikk mer og mer fascinerende grafikk, men dette endret ikke på hva man ellers så på skjermen. Det grunnleggende innholdet, som filer, programmer og vinduer, ble vist på akkurat samme måte som på Xerox Alto 30 år før.

Den nye personlige datamaskinen

I 2007 lanserte Apple sin første iPhone. Dette var egentlig en liten datamaskin som det også var mulig å ringe med. Først nå fikk vi en datamaskin som faktisk var personlig.

iPhonen snudde også om på de aller fleste ideene om hva en datamaskin skulle være. Skjermen var liten og man brukte berøringsskjerm istedenfor tastatur. Det var bare mulig å kjøre ett program om gangen og det var ingen muligheter for å håndtere filer.

Dette gjorde at en del følte at de mistet litt kontroll.

Men, brukerterskelen ble mye lavere. Det var svært få muligheter for å gjøre feil. Og datamaskinen hadde nå blitt en gjenstand som var tilgjengelig overalt, hele tiden. Man kunne putte den i lommen og den var tilkoblet internett, alltid.

Smarttelefonen, som den ble kalt, ble raskt allemannseie.

Hva nå? Ikke grafikk og datamaskiner

Utviklingen av datamaskiner var lenge styrt av ønsket om å få se informasjon på en skjerm. De tekniske framskrittene påvirket innovasjonen i ulike retninger, men datagrafikken la mye av grunnlaget for den brukervennligheten vi etter hvert har fått.

Datagrafikken gav oss også veldig raske prosessorer, GPU-ene. De ble først laget for å regne på tredimensjonal grafikk, men de har nå fått et helt nytt bruksområde: Å trene opp nevrale nettverk, et verktøy i maskinlæring. Og presis maskinlæring gjør blant annet at stemmestyring fungerer bedre enn før.

Dette gjør at vi i dag ikke trenger å tenke så mye på å lære oss maskinenes språk. De lærer seg vårt. Fra å se på sofistikert grafikk på en skjerm går vi videre til noe som er enda bedre: Å kunne bruke datamaskiner uten å legge merke til det. Grafikken har gjort seg selv overflødig.

Smarttelefonene bidro til å omdefinere hva en datamaskin skulle være. De, og nettbrettene, åpnet for helt nye måter å bruke datamaskiner på.

Berøringsskjermer, stemmegjenkjenning og nettsurfing fra sofaen fantes knapt før.

Denne utviklingen vil antagelig fortsette: Den klassiske datamaskinen med skjerm og tastatur erstattes gradvis av flere små og spesialiserte enheter som man kommuniserer med på nye måter.

Felles for alle de spesialiserte enhetene er at de har datamaskiner inni seg, men vi merker ikke lengre noe til selve datamaskinen i dem.

Datamaskinene er overalt, men samtidig ikke.

Saken er oppdatert med en rettelse: Datamaskinen Alto var ikke laget av DEC, men av Xerox.